Heute will ich mal kurz über das Projekt sprechen in dem ich nun seit fast einem Jahr an der TU Dresden arbeite: die Nachwuchsforschergruppe VICCI

VICCI steht für „Visual and Interactive Cyber-physical systems Control and Integration“.

Kernelement sind die Cyber-Physcial Systems (kurz: CPS). Fragt man zehn Leute was CPS sind, dann kriegt man zehn Antworten. Es ist nicht so ganz klar. Hier nun meine Meinung zu dem ganzen:

CPS sind „smarte“, (semi-)autonome Systeme (Netzwerke) aus Elementen (embedded Systems) die sowohl eine reale Bedeutung haben (z.B. Sensoren oder Aktoren) sowie eine virtuelle (Abbildung von Daten in Software). Die vernetzen Elemente zusammen bilden ein System, welches selbständig optimiert oder adaptiert und hierbei Prozesse in der realen Welt durchführt oder unterstützt.

Ok. Die Beschreibung macht das jetzt auch nicht wirklich klarer. Vielleicht so: CPS ist „Automatisierung 3.0“. Während klassische Automatisierung einfache Regelkreisläufe zur Steuerung benutzt oder lediglich eine Verbedienung für den Benutzer darstellt, können CPS komplexe Steuerungen selbständig optimieren. Typische Schlagwörter sind „Smart Factory“, „Smart Grid“, „Smart Office“, „Smart Home“, etc. Es geht immer darum, dass die Umgebung „mitdenkt“.

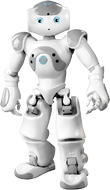

In VICCI verfolgen wir das Szenario des „Smart Home“, sprich eine Wohnung die mitdenkt und dem Bewohner hilft. Beispielsweise in dem Transport- und Suchaufgaben erledigt werden. Unser CPS besteht aus Sensoren und Aktoren. Die Sensoren sind in einem Laborraum verbaut, der die Wohnung repräsentieren soll. Hier sind es Temperatursensoren, Kameras, Lichtsensoren, Feuchtesensoren, etc. Als Aktoren haben wir Roboter angeschafft die wir als beispielhafte Service-Roboter nutzen werden. Ihr erinnert euch an I, Robot. Wir (Forscher) arbeiten daran ;-)

Mein Arbeitsbereich innerhalb der Gruppe ist (neben Koordinations- und Verwaltungsaufgaben) die Visualisierung des CPS, genauer, der interne Zustand des CPS. Ich erzeuge Darstellungen für die Analyse. Etwas plakativer: „Was denkt das CPS eigentlich gerade?“ ist die Frage die meine Visualisierung angehen soll. Erste Ergebnisse sind da, aber gerade noch nicht veröffentlicht. Sobald es was neues gibt, werde ich es natürlich auch hier vorstellen.